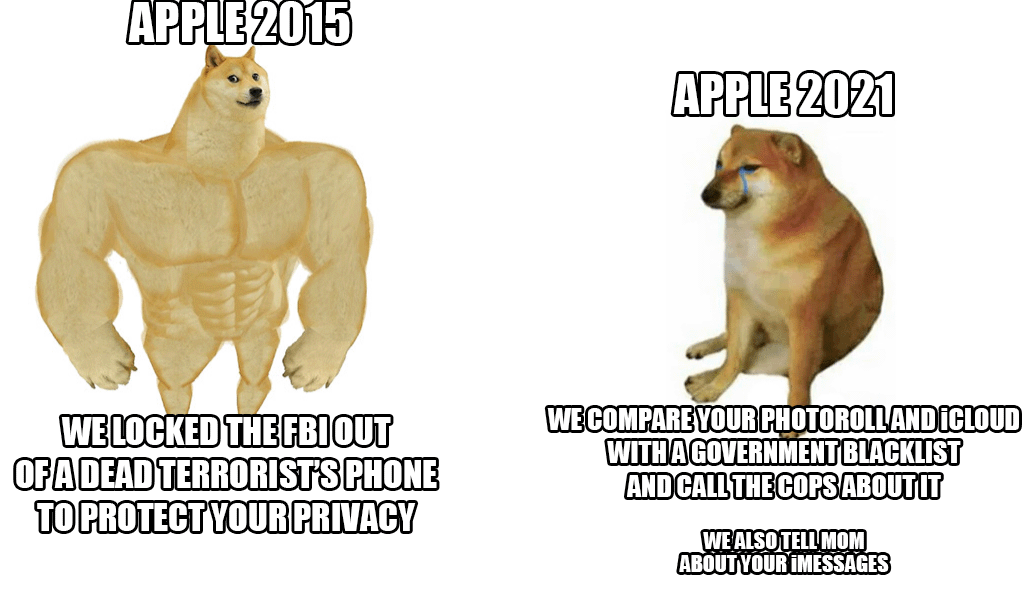

გასული კვირის ბოლოს, Apple-მა წარმოადგინა ბავშვებზე ძალადობის საწინააღმდეგო ახალი სისტემა, რომელიც სკანირებს პრაქტიკულად ყველას iCloud-ის ფოტოებს. მიუხედავად იმისა, რომ იდეა ერთი შეხედვით კარგად ჟღერს, რადგან ბავშვებს ნამდვილად სჭირდებათ დაცვა ამ მოქმედებისგან, კუპერტინო გიგანტი მაინც გააკრიტიკა ზვავმა - არა მხოლოდ მომხმარებლებისა და უსაფრთხოების ექსპერტებისგან, არამედ თავად თანამშრომლების რიგებიდანაც.

პატივცემული სააგენტოს ბოლო ინფორმაციით Reuters რამდენიმე თანამშრომელმა გამოხატა თავისი შეშფოთება ამ სისტემის შესახებ Slack-ზე შიდა კომუნიკაციაში. სავარაუდოდ, ისინი უნდა იყვნენ შეშფოთებული ხელისუფლებისა და მთავრობების მხრიდან შესაძლო ბოროტად გამოყენების გამო, რომლებმაც შეიძლება ბოროტად გამოიყენონ ეს შესაძლებლობები, მაგალითად, ადამიანების ან შერჩეული ჯგუფების ცენზურაზე. სისტემის გამოვლენამ გამოიწვია ძლიერი დებატები, რომელსაც უკვე აქვს 800-ზე მეტი ინდივიდუალური შეტყობინება ზემოხსენებულ Slack-ში. მოკლედ, თანამშრომლები შეშფოთებულები არიან. უსაფრთხოების ექსპერტებმაც კი ადრე გაამახვილეს ყურადღება იმ ფაქტზე, რომ არასწორ ხელში ეს იქნებოდა მართლაც საშიში იარაღი, რომელიც გამოყენებული იქნება აქტივისტების, მათი აღნიშნული ცენზურის და ა.შ.

კარგი ამბავი (ჯერჯერობით) არის ის, რომ სიახლე მხოლოდ შეერთებულ შტატებში დაიწყება. ამ დროისთვის ისიც კი არ არის ცნობილი, იქნება თუ არა სისტემა გამოყენებული ევროკავშირის ქვეყნებშიც. თუმცა, მიუხედავად ყველა კრიტიკისა, Apple თავისთავად დგას და იცავს სისტემას. ის, უპირველეს ყოვლისა, ამტკიცებს, რომ ყველა შემოწმება ხდება მოწყობილობის შიგნით და მას შემდეგ, რაც ხდება მატჩი, მხოლოდ იმ მომენტში ხდება საქმეს ხელახლა შემოწმება Apple-ის თანამშრომელი. მხოლოდ მისი შეხედულებისამებრ გადაეცემა შესაბამის ორგანოებს.

Ეს შეიძლება იყოს დაგაინტერესოთ

არ მინდა iCloud-დან გადახვიდე უსაფრთხო და ჭეშმარიტად კერძოზე, მაგრამ თუ Apple დაჟინებით მოითხოვს, მე მაინც შევწყვეტ მათ გადახდას.

ის აქტიური იქნება (ჯერჯერობით) მხოლოდ აშშ-ში

საკანონმდებლო საკანონმდებლო ასპექტს არ აქვს მნიშვნელობა. ეს ტექნოლოგია უკვე იქნება და განთავსდება. ეს არის ყველაზე დიდი რისკი.